Les dangers cachés derrière l’IA : une découverte alarmante

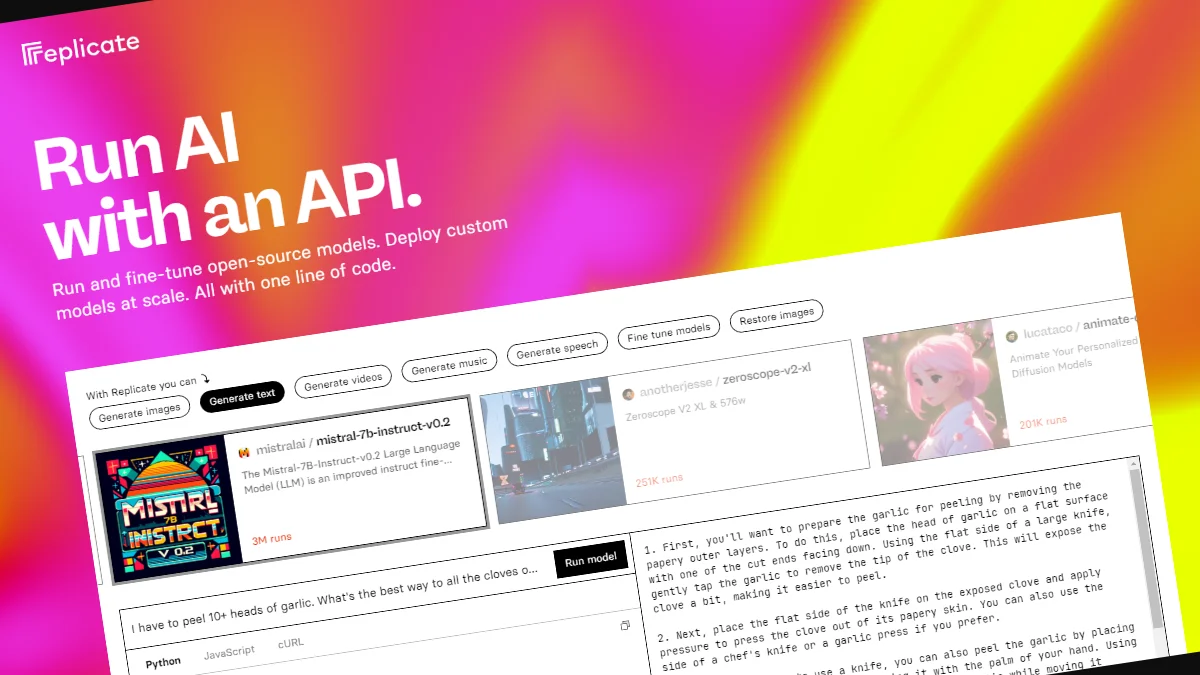

Dans une révélation choc, des experts en cybersécurité ont mis en lumière une faille critique au sein de Replicate, un fournisseur de services d’intelligence artificielle (IA). Cette vulnérabilité aurait permis à des acteurs malveillants d’accéder à des modèles d’IA propriétaires et à des informations sensibles, mettant en péril la confidentialité des données de tous les clients de la plateforme.

Une exploitation qui fait froid dans le dos

Selon le rapport publié cette semaine par l’entreprise de sécurité cloud Wiz, l’exploitation de cette vulnérabilité aurait pu permettre un accès non autorisé aux prompts et aux résultats des modèles d’IA de tous les utilisateurs de Replicate. En cause, le format de packaging des modèles d’IA, permettant l’exécution arbitraire de code et facilitant ainsi des attaques croisées entre les locataires grâce à un modèle malveillant.

Replicate utilise un outil open-source appelé Cog pour containeriser et packager les modèles d’apprentissage automatique, lesquels peuvent ensuite être déployés soit en environnement auto-hébergé, soit sur la plateforme de Replicate. Wiz a démontré qu’un conteneur Cog malveillant pouvait être utilisé pour obtenir une exécution de code à distance sur l’infrastructure de service de Replicate, avec des privilèges élevés.

Les mécanismes d’attaque révélés

Les chercheurs en sécurité Shir Tamari et Sagi Tzadik ont expliqué que cette technique d’exécution de code s’appuie sur une connexion TCP déjà établie associée à une instance de serveur Redis au sein d’un cluster Kubernetes hébergé sur Google Cloud Platform. Cela permettait d’injecter des commandes arbitraires. En manipulant le serveur Redis centralisé, utilisé comme file d’attente pour gérer les multiples requêtes clients et leurs réponses, les chercheurs ont découvert qu’il était possible de faciliter des attaques croisées en insérant des tâches malveillantes pouvant altérer les résultats des modèles des autres clients.

Des conséquences potentiellement dévastatrices

Ces manipulations malveillantes menacent non seulement l’intégrité des modèles d’IA, mais posent également des risques importants pour l’exactitude et la fiabilité des résultats générés par ces modèles. Un attaquant aurait pu interroger les modèles privés des clients, exposant potentiellement des connaissances propriétaires ou des données sensibles impliquées dans le processus d’entraînement des modèles. De plus, l’interception des prompts aurait pu révéler des informations personnelles identifiables (PII).

La faille, divulguée de manière responsable en janvier 2024, a depuis été corrigée par Replicate. Il n’existe aucune preuve que la vulnérabilité ait été exploitée dans la nature pour compromettre les données des clients.

Un avertissement pour l’industrie de l’IA

Cette divulgation survient un peu plus d’un mois après que Wiz a détaillé des risques similaires dans des plateformes comme Hugging Face, où des acteurs malveillants pourraient également escalader leurs privilèges, accéder aux modèles d’autres clients et même prendre le contrôle des pipelines d’intégration continue et de déploiement continu (CI/CD).

Tableau comparatif des risques et solutions

| Plateforme | Faille détectée | Potentiel d’exploitation | Actions correctives |

|---|---|---|---|

| Replicate | Accès non autorisé aux modèles et données | Injection de commandes arbitraires | Correction de la faille en janvier 2024 |

| Hugging Face | Escalade de privilèges, accès aux modèles | Prise de contrôle des pipelines CI/CD | Correctifs appliqués récemment |

Vers une sécurisation renforcée des services d’IA

Les modèles malveillants représentent un risque majeur pour les systèmes d’IA, en particulier pour les fournisseurs de services d’IA, car les attaquants peuvent les utiliser pour effectuer des attaques croisées. L’impact potentiel est dévastateur, les attaquants pouvant accéder à des millions de modèles et d’applications d’IA privés stockés chez les fournisseurs de services d’IA. Il est crucial que les entreprises adoptent des mesures de sécurité robustes pour protéger leurs modèles et données sensibles contre de telles menaces.